當(dāng)前位置:首頁(yè) > 學(xué)習(xí)資源 > 講師博文 > 生成對(duì)抗網(wǎng)絡(luò)(GAN)穩(wěn)定性提升:譜歸一化與梯度懲罰 聯(lián)合訓(xùn)練策略

生成對(duì)抗網(wǎng)絡(luò)(GAN)穩(wěn)定性提升:譜歸一化與梯度懲罰 聯(lián)合訓(xùn)練策略

時(shí)間:2025-05-28 來(lái)源:華清遠(yuǎn)見(jiàn)

生成對(duì)抗網(wǎng)絡(luò)(GAN)穩(wěn)定性提升:譜歸一化與梯度懲罰 聯(lián)合訓(xùn)練策略

時(shí)間:2025-05-28 來(lái)源:華清遠(yuǎn)見(jiàn)

生成對(duì)抗網(wǎng)絡(luò)(GAN)自 2014 年提出以來(lái),已成為生成模型領(lǐng)域的重要基石。它的基 本思想看似簡(jiǎn)單,卻面臨著諸如訓(xùn)練不穩(wěn)定、模式崩潰、梯度消失或爆炸等一系列問(wèn) 題。本文將聚焦于兩個(gè)近年來(lái)被廣泛研究的提升穩(wěn)定性的關(guān)鍵技術(shù) —— 譜歸一化

(Spectral Normalization) 和 梯度懲罰( Gradient Penalty) ,并探討它們?nèi)绾?協(xié)同工作以增強(qiáng)GAN的訓(xùn)練穩(wěn)定性與生成質(zhì)量。

一、 問(wèn)題背景: 為什么GAN難以訓(xùn)練?

傳統(tǒng)GAN訓(xùn)練時(shí),判別器 D 和生成器 G 是一種零和博弈的關(guān)系。理想情況下 D 和 G 會(huì)在競(jìng)爭(zhēng)中不斷進(jìn)步,但在實(shí)際訓(xùn)練中卻常常出現(xiàn)以下問(wèn)題:

判別器過(guò)強(qiáng)或過(guò)弱導(dǎo)致梯度信息缺失 訓(xùn)練過(guò)程中不平衡,判別器過(guò)擬合

模式崩潰( Mode Collapse)

損失函數(shù)不再反映模型質(zhì)量

因此,研究者們提出了多種正則化方法來(lái)控制判別器的“行為”,使得訓(xùn)練過(guò)程更加平 穩(wěn)。

二、譜歸一化(Spectral Normalization)

冷 原理簡(jiǎn)介

譜歸一化是一種通過(guò)約束判別器每一層權(quán)重的最大奇異值(譜范數(shù)) ,從而控制網(wǎng)絡(luò) Lipschitz 常數(shù)的技術(shù)。

簡(jiǎn)而言之,它通過(guò)將每一層的權(quán)重 W 歸一化為:

$W_ {SN} = \frac{W}{\sigma(W)} $ 其中 σ(W) 是矩陣 W 的最大奇異值。

✅ 優(yōu)點(diǎn)

控制判別器的 Lipschitz 常數(shù),防止梯度爆炸 收斂更快,訓(xùn)練更穩(wěn)定

無(wú)需額外的超參數(shù)(與梯度懲罰不同)

圓 應(yīng)用代表:SN-GAN

譜歸一化首次由 Miyato 等人在 2018 年的論文中提出,并應(yīng)用于 SN-GAN 中,效果顯 著優(yōu)于傳統(tǒng) GAN。

三、梯度懲罰(Gradient Penalty)

冷 原理簡(jiǎn)介

梯度懲罰的核心思想是: 約束判別器對(duì)輸入的梯度不能太大,從而保持 Lipschitz 連 續(xù)性。

在 WGAN-GP 中,懲罰項(xiàng)被添加到了損失函數(shù)中:

LGP = λ ⋅ (∥∇D()∥ 2 − 1)2

其中 x^ 是真實(shí)樣本與生成樣本之間的插值點(diǎn), λ 是權(quán)重系數(shù)。

✅ 優(yōu)點(diǎn)

可以控制判別器的梯度行為 適用于各種 GAN 架構(gòu)

能有效緩解模式崩潰問(wèn)題

⚠ 缺點(diǎn)

增加了計(jì)算復(fù)雜度

梯度估計(jì)可能不穩(wěn)定,需選好 λ

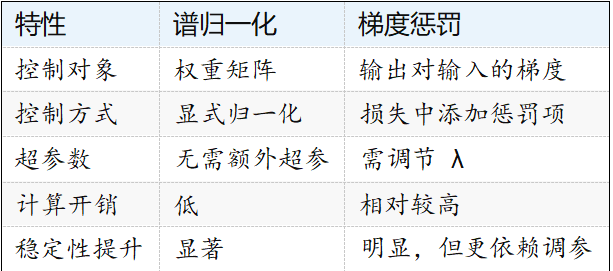

四、譜歸一化 vs 梯度懲罰

五、聯(lián)合策略:譜歸一化 + 梯度懲罰

在實(shí)際中,兩者結(jié)合使用可以取長(zhǎng)補(bǔ)短。譜歸一化控制網(wǎng)絡(luò)整體尺度,而梯度懲罰則精 細(xì)約束輸入輸出的敏感度。

爨 聯(lián)合策略核心思路:

1. 在判別器中使用譜歸一化來(lái)約束每一層的 Lipschitz 常數(shù)

2. 在損失函數(shù)中添加梯度懲罰項(xiàng)對(duì)輸入輸出變化進(jìn)行額外約束

3. 通過(guò)適當(dāng)調(diào)整梯度懲罰的權(quán)重 λ , 進(jìn)一步增強(qiáng)訓(xùn)練魯棒性

實(shí)踐效果

模型在初期收斂更平穩(wěn)

判別器不過(guò)擬合,生成器更易于優(yōu)化

在 CIFAR-10、Ce lebA 等數(shù)據(jù)集上,F(xiàn)ID 得分有顯著下降

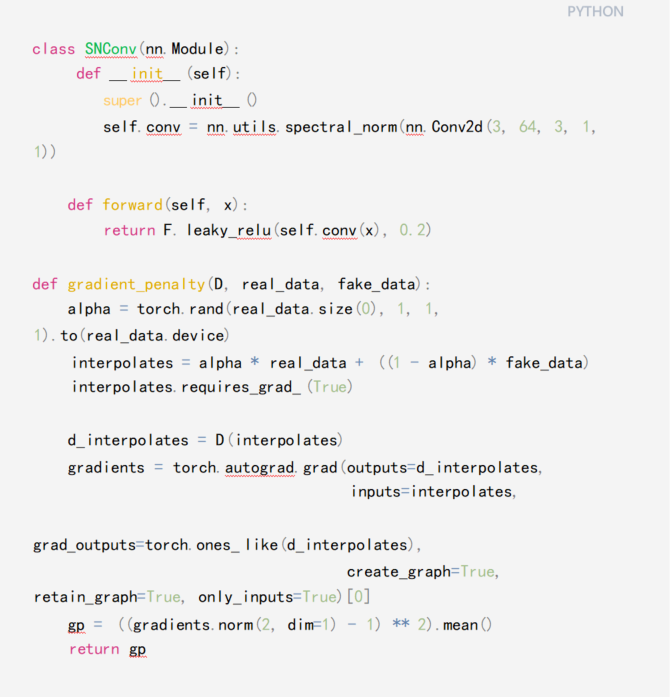

六、PyTorch 示例(偽代碼)

七、總結(jié)

譜歸一化與梯度懲罰本質(zhì)上都是為了實(shí)現(xiàn)判別器的平滑控制,它們分別從“參數(shù)空間” 和“輸入空間”兩個(gè)角度解決 GAN 的訓(xùn)練不穩(wěn)定性問(wèn)題。聯(lián)合使用這兩種技術(shù)可以有 效:

提高 GAN 訓(xùn)練穩(wěn)定性 緩解模式崩潰

提升生成樣本質(zhì)量

在今后的 GAN 架構(gòu)設(shè)計(jì)中,這種 “雙保險(xiǎn)式”的正則化策略 將成為提高模型可靠性的有 效手段。

課程分享:華清遠(yuǎn)見(jiàn)聯(lián)合NXP推出i.MX8M Plus開(kāi)發(fā)與實(shí)踐

課程分享:華清遠(yuǎn)見(jiàn)聯(lián)合NXP推出i.MX8M Plus開(kāi)發(fā)與實(shí)踐 課程分享:鴻蒙HarmonyOS系統(tǒng)及物聯(lián)網(wǎng)開(kāi)發(fā)實(shí)戰(zhàn)課程(

課程分享:鴻蒙HarmonyOS系統(tǒng)及物聯(lián)網(wǎng)開(kāi)發(fā)實(shí)戰(zhàn)課程( 課程分享:HaaS EDU K1開(kāi)發(fā)教程(附課程視頻及源碼下

課程分享:HaaS EDU K1開(kāi)發(fā)教程(附課程視頻及源碼下 新版C語(yǔ)言編程之控制語(yǔ)句視頻教程重磅贈(zèng)送(嵌入式入

新版C語(yǔ)言編程之控制語(yǔ)句視頻教程重磅贈(zèng)送(嵌入式入 價(jià)值2000元的嵌入式精裝教程大禮包免費(fèi)送!(搞懂嵌入

價(jià)值2000元的嵌入式精裝教程大禮包免費(fèi)送!(搞懂嵌入 價(jià)值1000元的最新ARM系列視頻完整版教程新鮮出爐(免

價(jià)值1000元的最新ARM系列視頻完整版教程新鮮出爐(免 【最新】ARM課程課堂實(shí)錄精華版視頻免費(fèi)領(lǐng)取(內(nèi)含源

【最新】ARM課程課堂實(shí)錄精華版視頻免費(fèi)領(lǐng)取(內(nèi)含源 嵌入式 GPU 的圖形加速技術(shù)解析

嵌入式 GPU 的圖形加速技術(shù)解析 生成對(duì)抗網(wǎng)絡(luò)(GAN)穩(wěn)定性提升:譜歸一化與梯度懲罰

生成對(duì)抗網(wǎng)絡(luò)(GAN)穩(wěn)定性提升:譜歸一化與梯度懲罰  嵌入式實(shí)時(shí)操作系統(tǒng)(RTOS)中混合關(guān)鍵性任務(wù)調(diào)度策略

嵌入式實(shí)時(shí)操作系統(tǒng)(RTOS)中混合關(guān)鍵性任務(wù)調(diào)度策略 基于因果推理的時(shí)序數(shù)據(jù)異常檢測(cè)與根因定位模型設(shè)計(jì)

基于因果推理的時(shí)序數(shù)據(jù)異常檢測(cè)與根因定位模型設(shè)計(jì) 強(qiáng)化學(xué)習(xí)(RL)在機(jī)器人抓取任務(wù)中的稀疏獎(jiǎng)勵(lì)與課程學(xué)

強(qiáng)化學(xué)習(xí)(RL)在機(jī)器人抓取任務(wù)中的稀疏獎(jiǎng)勵(lì)與課程學(xué) 嵌入式多核處理器中的任務(wù)遷移與負(fù)載均衡算法設(shè)計(jì)與性

嵌入式多核處理器中的任務(wù)遷移與負(fù)載均衡算法設(shè)計(jì)與性 基于事件驅(qū)動(dòng)的嵌入式系統(tǒng)低功耗設(shè)計(jì):從傳感器采樣到

基于事件驅(qū)動(dòng)的嵌入式系統(tǒng)低功耗設(shè)計(jì):從傳感器采樣到 基于 Zephyr RTOS 的嵌入式藍(lán)牙 Mesh 網(wǎng)絡(luò)節(jié)點(diǎn)設(shè)計(jì)與

基于 Zephyr RTOS 的嵌入式藍(lán)牙 Mesh 網(wǎng)絡(luò)節(jié)點(diǎn)設(shè)計(jì)與 超大規(guī)模模型訓(xùn)練中的 ZeRO 優(yōu)化器與混合精度通信壓縮

超大規(guī)模模型訓(xùn)練中的 ZeRO 優(yōu)化器與混合精度通信壓縮 聯(lián)邦學(xué)習(xí)(FL)中的梯度噪聲注入與差分隱私保護(hù)平衡策略

聯(lián)邦學(xué)習(xí)(FL)中的梯度噪聲注入與差分隱私保護(hù)平衡策略